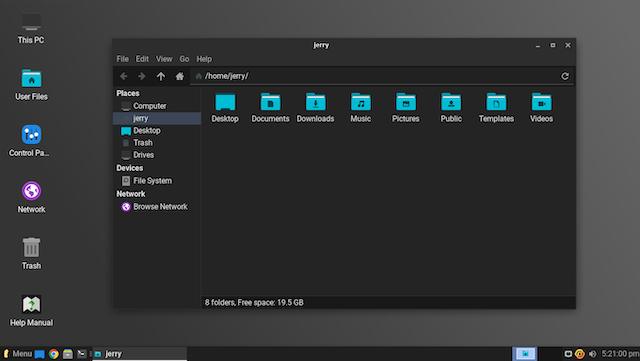

Ubuntu 22.04已经发布,我们将开始看到随后那些基于Canonical操作系统的所有Linux发行版的更新。例如,基于Ubuntu 22.04的Linux Lite 6.0的第一个候选版本现在已经推出,Linux Lite在那些从微软Windows转到Linux的人中非常受欢迎。

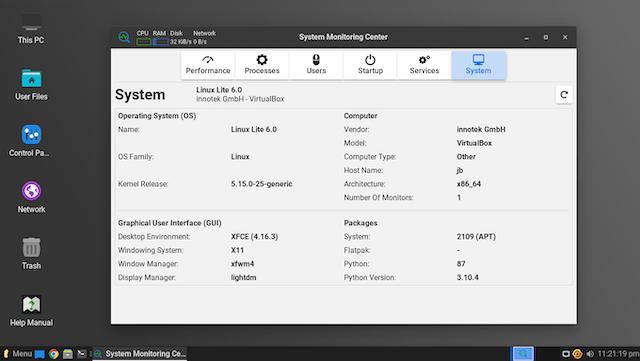

Linux Lite 6.0 RC1的显著特点是抛弃了Mozilla Firefox作为默认网络浏览器,而改用Goole Chrome 100。该操作系统目前使用Linux内核5.15.0-25和桌面环境Xfce 4.16.3。它预装了一些优秀的软件,如GIMP 2.10.30、雷鸟91.7.0、VLC 3.0.16和LibreOffice7.2.6.2。

“这个系列的主题是包容和新鲜。最新的浏览器,最新的办公套件,最新的定制软件。我的目标一直是提供一个精简的、功能齐全的操作系统。在6x系列中,这将是我们持续关注的焦点。这个版本的新功能是辅助技术。以屏幕阅读器、桌面放大器和虚拟键盘的形式出现。所有的工具都确保我们的听力和视力受损的社区不再被遗忘。一个新的主题,一个新的系统监视器和管理器完善了主要的新功能,”Linux Lite首席开发者Jerry Bezencon说。

Bezencon补充说:”现在,Firefox作为Ubuntu的一个Snap包,而用户需要能够处理尽可能少的包管理器,在这种情况下,Chrome是明显的替代选择。巨大的市场份额,熟悉的Windows系统,几乎所有你扔给它的东西都能用,所有这些都有一个叫Google的小公司的支持。我们还包括一个由Virus Total提供的内置病毒扫描引擎(默认禁用)。现在,Chrome浏览器还会询问你是否希望在打开文件之前对其进行扫描。要启用这一功能,只需在Chrome扩展程序下将其打开即可”。

开发人员在下面分享了已知的问题:

在传统安装结束时没有弹出媒体的提示,在UEFI安装结束时有提示。

发行说明 – 在第一个安装程序幻灯片上不起作用。

桌面图标 – 仅支持英文。

Dropbox:如果遭遇报错,需要运行设置两次。

由于一个无法解决的问题,在这个系列的Linux Lite Tweaks中没有Grub编辑功能。如果你是双启动或多启动,Ubuntu字样将显示在Grub菜单中,如果觉得看着不舒服,可以试试Grub定制器。

Grub菜单显示Linux Lite为”Ubuntu”。

如果你已经准备好尝试Linux Lite 6.0 RC1,你现在可以在这里下载它。请记住,这只是一个候选版本 — 可能会有一些错误。换句话说,不应该在生产环境中进行。最终版本计划于2022年6月1日发布;如果你打算在你的主电脑上使用它,等待稳定版本是明智的。